1. Pesquisa experimental e Pesquisa observacional

1.1 Indução e experimentos

As pesquisas científicas podem assumir alcances diversos, mas o objetivo principal da ciência é construir modelos teóricos que expliquem os fenômenos empíricos a partir da identificação das suas causas e de seus efeitos. Para tanto, o pesquisador observa fatos existentes no mundo e busca formular explicações que sejam compatíveis com essas observações. Como o procedimento de pesquisa é baseado na observação de fatos, esse tipo de pesquisa é chamado de pesquisa empírica.

Quando possível, o pesquisador elabora uma hipótese explicativa (por exemplo, a de que determinado medicamento é eficaz contra a Covid-19) e cria experimentos (situações artificialmente criadas) voltados a testar a compatibilidade de uma hipótese com os fatos observados. Por exemplo, uma equipe médica pode oferecer uma vacina a um grupo de pessoas e oferecer placebo a outro grupo (criando assim uma situação artificial) para identificar se existe diferença nas taxas de infecção de Covid em cada um desses grupos. Neste caso, além de empírica, a pesquisa é qualificada como experimental.

Embora a ciência esteja sempre ligada à observação de fatos, ela não se limita a descrever os fenômenos observados, pois seu objetivo final é a formulação de explicações. Essas explicações precisam ir além das descrições, estabelecendo conexões entre esses fatos, que permitam a identificação de padrões (por exemplo, o padrão de que pessoas que tomam certa substância se infectam menos do que um grupo que não a toma).

A ciência parte da observação de uma série de fatos concretos particulares (por exemplo, a ocorrência ou não de doenças em cada um dos indivíduos observados) e, a partir de tais fatos, ela produz afirmações de caráter geral, que devem ser válidas para uma classe de fenômenos e não apenas para os fatos concretos que foram observados pelo pesquisador (por exemplo, a eficácia da vacina deve ser medida para a população em geral e não apenas para as pessoas que participaram do estudo).

Essa passagem da descrição de fenômenos particulares para a formulação de explicações gerais é o que chamamos de indução, que é o modo de raciocínio típico da pesquisa científica.

O direito normalmente opera no sentido oposto: partimos de certas regras gerais, que pressupomos como sendo válidas, e buscamos deduzir dessas prescrições abstratas as consequências que elas imputam aos fatos particulares. A dedução é um processo que extrai consequências dos conhecimentos que temos, consolidados na premissa maior dos argumentos, mas que não têm por objetivo oferecer informações novas.

Há séculos, temos plena consciência de que a indução é uma dinâmica sujeita a muitos problemas, especialmente porque nós nunca podemos observar diretamente os padrões que descrevemos. Explicações não são descobertas, não são observadas, não são percebidas: elas são formuladas, por meio de inferências. Essas inferências representam um salto importante, mas arriscado: usar o conhecimento que temos sobre fatos particulares que conhecemos, para projetar conclusões relativamente a toda uma classe de fenômenos (composto majoritariamente por fatos que não conhecemos). Mas ocorre que nossas inferências muitas vezes nos levam a generalizações equivocadas.

Assim, a dedução é um processo seguro, mas limitado aos conhecimentos que já temos. Já a indução é um processo arriscado, mas é nossa única via aberta para construir novos conhecimentos.

Por serem treinados a operar um discurso dedutivo, os juristas muitas vezes não têm instrumentos para compreender o potencial (e os limites) dos discursos indutivos da ciência. Portanto, não deve causar espanto que Epstein e King, ao analisarem a produção acadêmica em direito nos EUA no início do século XXI, tenham afirmado:

Nossa proposta era identificar onde os problemas estavam. Nossa resposta? Em todos os lugares. Descobrimos que graves problemas de inferência e de metodologia constam em abundância em todos os lugares onde achamos pesquisa empírica em periódicos jurídicos e artigos escritos por membros da comunidade jurídica. (Epstein e King 2013)

Embora essa dificuldade seja particularmente nítida no campo jurídico, não se tata de um problema exclusivo dos juristas. Tampouco se trata de uma dificuldade dos tempos modernos. É conhecido o exemplo de que os europeus observaram as aves e concluíram que os cisnes são aves brancas, um conhecimento que era compatível com a experiência europeia de observação de aves. Porém, quando os europeus chegaram à Austrália, descobriram a existência de cisnes negros. Esse é um caso simples, mas que ilustra a nossa grande dificuldade em construir um conhecimento sólido a partir de observações que são sempre limitadas e contextuais.

Desde os textos seminais de David Hume, no final do século XVIII, todo pesquisador é levado a se perguntar sempre: que conclusões eu posso efetivamente retirar dos fatos que eu observo? A reflexão sobre esses limites levou o filósofo Karl Popper a descrever uma assimetria entre as operações de comprovação e de falseamento: um conjunto incontável de observações particulares não assegura a validade de uma lei universal, ao passo que uma única observação dissonante é suficiente para rejeitá-la.

No campo da física, esse é um problema sério, mas que é relativamente equacionado porque que os cientistas supõem (sem poderem demonstrar) que as relações naturais entre fatos são regulares, pois a natureza opera segundo padrões predeterminados que não se alteram ao longo do tempo. Quando se observa o tempo que uma maçã leva para cair de uma árvore, espera-se que esse tempo não varie se todas as condições forem mantidas.

Essa crença na regularidade é a intuição que nos faz desenvolver experimentos: se conseguirmos repetir consistentemente certos atos, esperamos que os resultados das nossas condutas sejam idênticos. Porém, se conseguirmos praticar atos que sejam iguais em tudo, exceto em um determinado ponto no qual inserimos intencionalmente uma diferença, conseguiremos avaliar o impacto dessa diferença nos resultados alcançados.

Isso é o que chamamos de isolar as influências de um determinado fator: quando criamos artificialmente uma série de fenômenos que são idênticos, exceto na variação que inserimos neles, nós conseguimos isolar os efeitos dessa variação. Por esse motivo, a noção de ceteris paribus é fundamental na ciência: os pesquisadores buscam identificar qual seria o resultado da variação de um elemento determinado, quando todos os outros elementos de um fenômeno (ceteris) permanecem constantes (paribus).

Como indicado no início deste texto, os eventos artificialmente desenhados e rigorosamente controlados são o que chamamos de experimentos, e são eles nossa principal ferramenta para testar os efeitos de cada variação específica: no peso de uma bola que é arremessada, na quantidade de ácido que colocamos em uma reação química, dos estímulos que são feitos a certas pessoas. Compreende-se, portanto, como experimento o estudo em que o pesquisador manipula intencionalmente uma ou mais variáveis (chamadas independentes) e analisa os efeitos provocados por essa manipulação (denominada tratamento) sobre determinadas características do fenômeno estudado (chamadas variáveis dependentes) (Sampieri e outros 2013).

As ciências experimentais, como a medicina, desenvolveram uma série de estratégias voltadas a realizar esse isolamento de variáveis, de forma a permitir que se avalie com precisão qual é o impacto de um determinado fator (como a administração de um fármaco) em um determinado sistema (como a saúde de uma pessoa).

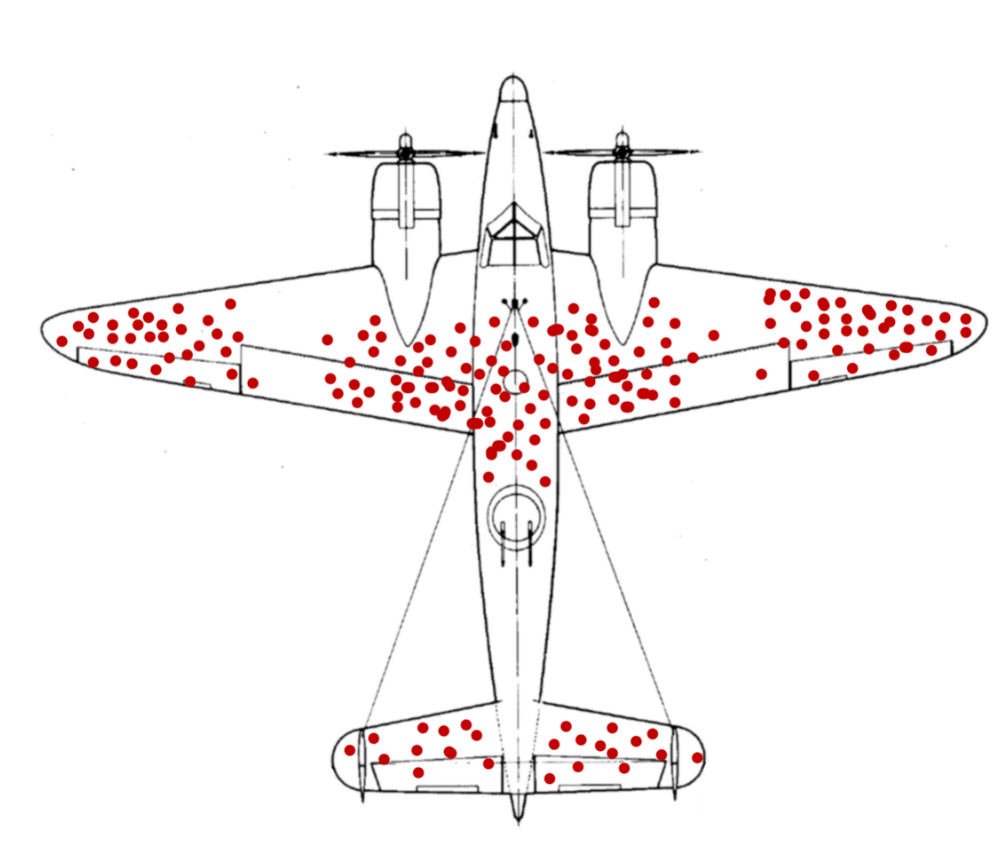

Ocorre, porém, que a dificuldade de realizar esse tipo de isolamento é gigantesca. Vários experimentos foram feitos, no contexto da pandemia de Covid-19, para avaliar a eficácia de certos tratamentos, mas a interpretação dos dados obtidos é desafiadora, pois cada ser humano é particular. O ótimo seria poder comparar qual é o desenvolvimento de um quadro clínico com e sem a administração do fármaco, mas isso é impossível, visto que não se pode, ao mesmo tempo, tratar e não tratar um paciente determinado.

Essa impossibilidade faz com que a medicina use uma outra forma de abordagem, baseada na estatística: como não é possível comparar as consequências da aplicação e da não aplicação de um fármaco a um indivíduo, o que se faz é aplicar o tratamento a um grande grupo de pessoas e comparar o seu desenvolvimento com outro grupo de pessoas (o chamado grupo de controle), que não recebe o mesmo estímulo.

Essa estratégia não consegue distinguir o impacto do remédio em cada caso concreto, mas pode nos revelar o impacto predominante do tratamento. Pode ser que alguns dos participantes de um estudo se curem mais rapidamente por razões genéticas, pelo estado especial do seu sistema imunológico ou por sua alimentação peculiar. Além disso, nós sabemos que cada pessoa reage de modo particular aos tratamentos, que podem ser ineficazes pelas características pessoais de cada paciente.

Cientes dessa dificuldade de avaliar o impacto de um medicamento em uma pessoa determinada (diferenciando-o de todos os outros fatores que poderiam explicar o andamento da doença), os pesquisadores optam por fazer as pesquisas com grandes grupos: se fizermos essa aplicação em uma população suficientemente grande, poderemos saber qual é o impacto médio do tratamento estudado.

Se o grupo que receber o remédio for muito pequeno, não saberemos em que medida o resultado final será determinado por situações particulares de cada indivíduo. Se esse grupo for muito homogêneo com relação a certas características (por exemplo, composto só por mulheres ou por pessoas de uma família), não saberemos se o mesmo resultado ocorreria em outros grupos (que tivessem um componente genético ou ambiental diferente).

Como não é viável fazer esses experimentos com todas as pessoas ao mesmo tempo, resta-nos escolher amostras representativas, que nos permitam inferir que os resultados alcançados em um grupo restrito (a amostra) são próximos aos que são esperados para o universo total dos casos possíveis. Porém, é preciso tomar um cuidado extremo para que a amostra seja significativa, pois amostras enviesadas podem comprometer a pesquisa. No momento em que escrevemos, a União Europeia indicou que uma vacina contra a Covid não deve ser usada com maiores de 65 anos porque a sua eficácia foi testada em uma população mais jovem, e ninguém pode garantir que ela terá com o mesmo grau de eficácia em pessoas mais velhas.

Outra técnica utilizada para evitar a constituição de amostras enviesadas consiste na seleção aleatória ou por sorteio das unidades de análise. A combinação de grupos de tamanho adequado com a seleção por sorteio reduz, drasticamente, a

probabilidade de formação de grupos experimental e controle com diferenças significativas nas características que possam ser relevantes para o experimento, afastando, na prática, o risco de contaminação por outras variáveis.

Embora a amostragem aleatória seja a técnica mais indicada, a equivalência entre os grupos a serem comparados também pode ser obtida pela técnica de emparelhamento, consistente em igualar os grupos em relação às variáveis que possam, na visão dos pesquisadores e da literatura preexistente, influenciar a

variável dependente. Um exemplo de emparelhamento seria a designação do mesmo número de pessoas do sexo masculino, idosas e hipertensas para os grupos experimental e controle em uma pesquisa de saúde que considerasse tais características (sexo, idade e condição prévia do sistema circulatório) como

covariáveis capazes de modificar os resultados.

Esse tipo de abordagem supõe que um conhecimento sólido somente pode ser alcançado a partir de experimentos feitos com grandes números de pessoas, divididas em grupos heterogêneos, e que os resultados devem ser comparados com os de um grupo de controle que tenha uma composição similar. Além disso, como sabemos que a realização de um tratamento pode influenciar psicologicamente as pessoas, entendemos que o grupo de controle deve receber um placebo, sem saber se recebe o remédio ou uma substância destituída de efeitos farmacológicos.

Essa estratégia de abordagem (ou seja, esse método) nos oferece a possibilidade de ter o conhecimento mais sólido atualmente disponível acerca da efetividade de tratamentos médicos. Podemos pensar em outras possibilidades, como a criação de conjuntos de células idênticos, para ser possível comparar os resultados em um organismo similar do tratamento com o fármaco e da ausência de tratamento. Podemos inclusive clonar organismos, para avaliar o impacto em organismos idênticos, e não apenas e em conjuntos de células.

Mas uma coisa é pensar nas melhores estratégias em um mundo sem constrangimentos, e outra coisa é se esses métodos são viáveis:

- em termos financeiros, pois a pesquisa é uma atividade muito cara e existe uma necessidade de obter a melhor relação custo-benefício entre certeza e investimento;

- em termos de tempo, pois muitas vezes precisamos tomar decisões que não podem esperar o tempo necessário para uma pesquisa metodologicamente sólida (como tem sido o caso no enfrentamento da Covid-19, pois os pacientes infectados precisam receber tratamento imediato);

- em termos éticos, pois há situações em que os experimentos não podem ser iniciados ou precisam ser abandonados (como um experimento com fármacos que dão indícios de uma mortalidade muito grande no grupo que recebia o tratamento que não seja ético continuar o experimento).

Assim, por mais que certos métodos garantam conhecimentos mais sólidos, é muito comum que pesquisadores optem por abordagens que geram resultados menos confiáveis, mas que são as abordagens possíveis, dados os constrangimentos reais do mundo.

As escolhas acerca das abordagens mais adequadas para uma pesquisa envolvem um conhecimento acerca dos métodos, que chamamos de metodologia. Por esse motivo, denominamos metodologia a seção de um trabalho voltada à explicação e à justificação das estratégias de abordagem utilizadas no trabalho.

1.2 Conhecimento observacional e inferências empíricas

Em vastas áreas do conhecimento humano, especialmente nas ciências sociais, a estratégia de realizar experimentos é inviável. Poderia ser interessante distribuir a mesma ação para um grupo de juízes homens e para um grupo de juízas mulheres, para avaliar as diferenças nos padrões de julgamento. Mas esse é um experimento que violaria as leis do país, pois não podemos distribuir casos fictícios nem podemos distribuir o mesmo caso para vários magistrados.

Na pesquisa jurídica, especialmente nos estudos judiciários, praticamente não nos é dado criar experimentos voltados a isolar variáveis. O que podemos fazer é observar os fatos que ocorrem, sem qualquer manipulação experimental, e usar estratégias de abordagem que permitam compreender se certos fatores poderiam ou não influir nos resultados. Como não existe um isolamento das variáveis tratadas, as conclusões dos estudos observacionais são menos sólidas do que as conclusões dos estudos experimentais. Todavia, é possível chegar a conclusões muito importantes quando tomamos cuidados variados para analisar as situações observadas de forma a tentar identificar a influência de cada variável analisada.

Podemos comparar os processos julgados por homens e mulheres. Podemos selecionar grupos de processos suficientemente parecidos para que eventuais diferenças no padrão de julgamento sejam atribuíveis ao gênero e não a outros fatores. Porém, toda pesquisa observacional tem limitações claras em termos de isolamento de variáveis, o que dificulta identificar com alto grau de certeza a ocorrência de relações de causalidade.

Já identificamos que as ADIs ajuizadas por partidos políticos têm uma maior incidência de decisões de prejudicialidade (Costa e Benvindo 2013, Costa e Costa 2018). Isso é um fato empírico observado. Mas qual é a explicação para esse fato? Pode estar no tipo de assunto que os partidos levam ao STF, pode estar no tipo de lei impugnada, pode estar no fato de a impugnação ser feita por partidos de oposição, pode ser que os partidos tenham estratégias políticas que favoreçam esse resultado, pode ser que os ministros decidam de forma diferente ações propostas por partidos. Pode ser, também, que todos esses fatores atuem simultaneamente e que tenham diferentes pesos nos processos de cada estado, ou de cada matéria.

A tentativa de estabelecer modelos explicativos a partir de pesquisas observacionais (que partem da descrição de um conjunto de fenômenos) exige dos juristas uma série de cuidados que normalmente eles não são treinados para ter. O modelo de redação de pareceres e petições estimula os juristas a identificar uma tese e a defendê-la, mesmo que não haja evidências sólidas em seu favor. Além disso, boa parte dos discursos dos juristas é avessa a qualquer argumentação baseada em evidências, pois a discussão sobre a interpretação correta de uma norma tipicamente não é definida com base na observação de fatos, mas se constitui como um exercício hermenêutico de caráter dedutivo e sistemático.

No que toca à metodologia, o grande desafio dos juristas é o de limitar-se a extrair dos fatos aquilo que é razoável, em vez de efetuar todos os esforços argumentativos possíveis no sentido de manter a hipótese explicativa sustentada pelo pesquisador.

Toda pesquisa empírica envolve um problema, uma questão a ser abordada a partir da análise de dados obtidos pela observação de experimentos controlados ou de situações não controladas.

Se a sua pesquisa se pergunta sobre a interpretação correta de uma norma, ela não tem um objeto empírico, porque não podemos identificar uma interpretação correta a partir de evidências factuais. O que torna uma interpretação correta não é a sua correspondência a certos fatos observáveis, mas a sua adequação a certos parâmetros dogmáticos, a certos cânones de interpretação.

Todavia, na dogmática jurídica contemporânea, são usados critérios hermenêuticos que se vinculam a elementos empíricos. Por exemplo, existe responsabilidade civil de indenizar danos, independentemente de culpa, "quando a atividade normalmente desenvolvida pelo autor do dano implicar, por sua natureza, risco para os direitos de outrem" (CC, art. 927, parágrafo único). Por mais que o conceito normativo de risco seja um construto da hermenêutica jurídica, são viáveis pesquisas que busquem mensurar os danos que são causados tipicamente pela prática de certas atividades, pois esse elemento empírico (danos tipicamente causados) pode ser entendido como um indicador do risco.

Uma pesquisa que se volte a identificar a interpretação correta do vocábulo "risco", no contexto da responsabilidade civil, não se pergunta sobre fatos do mundo, mas sobre o significado jurídico de uma palavra. Formulado dessa forma, o problema não aponta para uma pergunta que possa ser respondida tomando como referência evidências identificadas em uma pesquisa. Contudo, quando buscamos identificar e mensurar os danos causados a terceiros por uma certa atividade (como mineração ou transporte público), nós fazemos uma pergunta empírica cujo resultado tende a influenciar na interpretação acerca da responsabilidade civil das pessoas que praticam essa atividade.

Se fenômenos empíricos não forem relevantes para a resposta à sua questão (como é o caso normalmente das perguntas dogmáticas), você não tem propriamente um problema de pesquisa. Você pode ter um tema de estudo, pode ter uma tese a ser defendida, mas não tem um elemento que justifique a realização de uma pesquisa. Todavia, existe muito espaço para que você formule questões empíricas cuja resposta é viável e que podem ter impacto em questões hermenêuticas e dogmáticas.

Isso ocorre porque a pesquisa precisa ser uma abertura ao mundo: é preciso que as suas observações da realidade possam influenciar na resposta da questão que você se propôs. É preciso que a sua metodologia estabeleça uma estratégia de abordagem capaz de utilizar certas observações factuais em critérios de avaliação das hipóteses, ou de atingimento dos objetivos dos trabalhos.

Pesquisas experimentais normalmente estão ligadas a testar uma hipótese, visto que o experimento é construído justamente para servir como esse teste. Pesquisas observacionais normalmente não têm como testar hipóteses de forma tão direta, mas elas precisam estar ligadas com o desenvolvimento de estratégias capazes de alcançar certos objetivos que contribuam para um conhecimento mais adequado dos objetos de pesquisa:

- pode se tratar de uma coleta de dados que permita a formulação de hipóteses posteriores (o que ocorre em uma pesquisa exploratória);

- esses dados podem ser inseridos em modelos descritivos, que permitirão eventualmente a construção de explicações plausíveis (o que ocorre em uma pesquisa que tem um problema descritivo);

- pode-se chegar ao ponto de fazer inferências a partir dos dados obtidos na pesquisa (ou em outras coletas de dados já realizadas).

Portanto, seja experimental ou observacional, a pesquisa deve estar ligada à questão da inferência: o que os fatos observados pelo pesquisador permitem inferir acerca do seu objeto de pesquisa? De que forma a observação de certos elementos particulares permite a identificação de um padrão? A causalidade é um dos padrões possíveis, mas a identificação de correlações é um passo muito importante para entender como os fenômenos efetivamente ocorrem.

2. A definição do objeto empírico

Um dos pontos fundamentais da pesquisa é identificar com precisão qual é o objeto da investigação. Esse objeto deve estar referido diretamente pelo problema de pesquisa, que é uma pergunta acerca de algo: esse algo é justamente o objeto da pesquisa.

Ocorre que, para compreender o objeto da pesquisa, é preciso fazer um processo de coleta de dados, em busca de informações que nos digam algo com relação ao nosso objeto. Se queremos saber sobre os padrões de julgamentos de ADIs, sobre o modo como o STJ lida com precedentes ou sobre a potencial eficácia de certas estratégias de formulação de políticas públicas judiciárias, precisamos definir com clareza quais serão as informações que julgamos ser possíveis produzir e cuja análise pode responder ao nosso problema de pesquisa.

Nesse processo de definição dos dados a serem buscados, algumas abordagens diferentes são possíveis, que vão conduzir a desenhos de pesquisa bastante diversos. Como a área jurídica é pouco propensa a experimentos, trataremos aqui apenas de estratégias observacionais.

2.1 Estudos censitários e amostrais

Para ter conhecimentos acerca da população, o modo aparentemente mais seguro seria o de realizar uma análise de cada um dos indivíduos que fazem parte da população. Esse é um tipo de pesquisa que muitas vezes é cara e demorada, tanto que o Brasil somente faz um mapeamento censitário (ou seja, que levanta informações sobre todos os indivíduos da população estudada) de seus cidadãos a cada 10 anos, e levanta um número de dados bastante restrito com relação a eles.

Com o tempo, desenvolvemos instrumentos que nos permitem levantar dados com relação a um grupo pequeno de indivíduos e inferir, com certa segurança, as características gerais da população que eles integram. Chamamos de amostra esse pequeno grupo, que é efetivamente analisado. E chamamos de universo amostral o grupo a partir do qual a amostra foi selecionada. Em muitos casos, a pesquisa por amostra é mais segura do que as abordagens censitárias, que são normalmente incapazes de levantar dados sobre a totalidade dos indivíduos.

Imagine que o censo dos brasileiros, feito pelo IBGE, consiga atingir 90% dos lares, o que envolve um esforço imenso. Aparentemente, as conclusões seriam sólidas a partir de uma amostra tão grande, mas é possível que a maior parte das pessoas que não conseguiram ser entrevistadas sejam pessoas em situação de vulnerabilidade. A depender do perfil dessas pessoas que ficam excluídas do censo, o resultado da investigação poderia ser tão distante da realidade que uma pesquisa de caráter amostral, feita com os devidos cuidados, nos daria resultados mais sólidos.

Em boa parte dos casos de pesquisas de mestrado, não é possível ter (em tempo hábil e a custo factível) informações sobre todo o conjunto de objetos que se pretende mapear e explicar. Por isso, o mais comum nas ciências sociais é que o pesquisador se veja na necessidade de promover uma restrição muito grande da população estudada (para poder fazer uma análise exaustiva de suas unidades) ou de optar pela definição de uma amostra.

No campo jurídico, a escolha do caminho amostral tem a dificuldade particular de que as faculdades de direito não oferecem formação estatística a seus estudantes. Com isso, o desenvolvimento dessas habilidades pode se tornar um requisito necessário para a realização de certos tipos de pesquisa.

Por sua vez, a abordagem censitária também tem as suas dificuldades, pois é comum que ela exija tempo e investimentos que são incompatíveis com os mestrados. Uma exceção importante aqui é a pesquisa de dados, pois o processo de informatização dos tribunais gerou uma multiplicidade de dados (como as decisões) e de metadados (as classificações realizadas pelo tribunal, como os tipos de decisão) que são acessíveis aos pesquisadores. Com isso, no que toca à pesquisa de dados, é possível realizar recortes censitários sem que seja necessária uma multiplicação dos custos e do tempo.

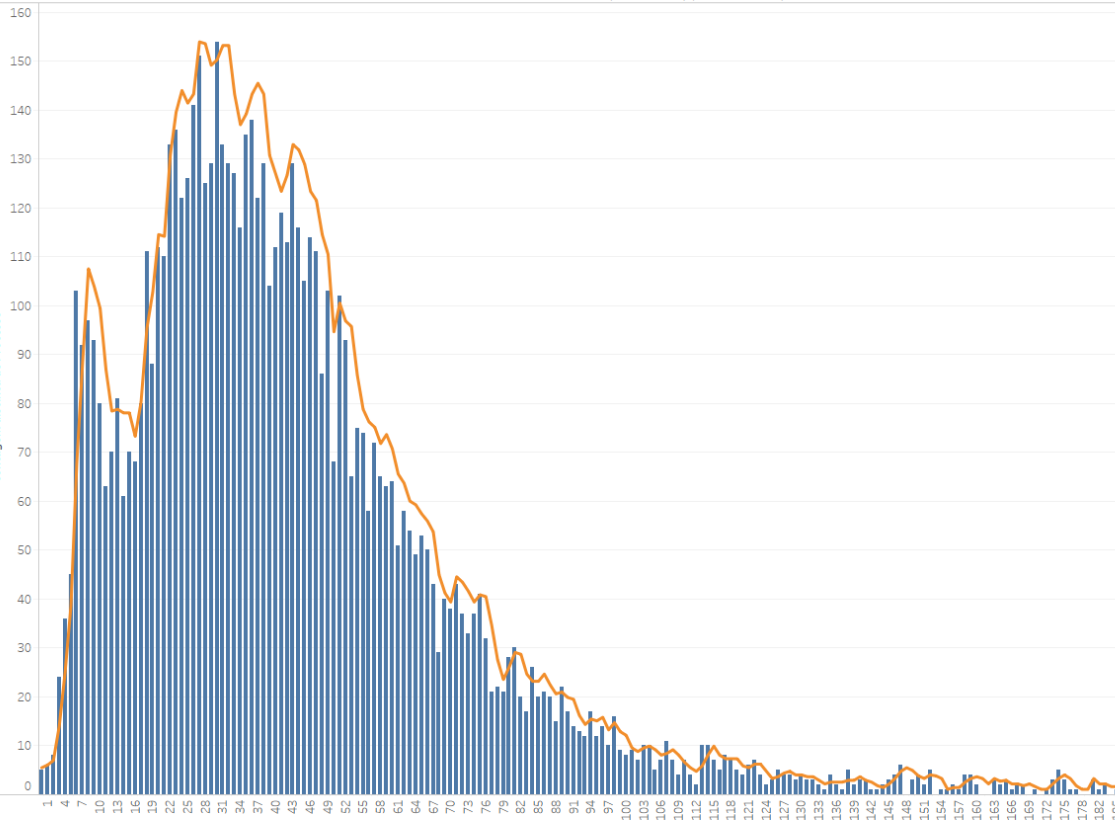

Essas pesquisas envolvem o desenvolvimento de capacidades específicas, em termos de descrição e análise de dados, que também demandam tempo e dedicação dos estudantes que desejam se capacitar. Essa capacidade de interpretar os dados também tem uma interface com a estatística, mas com a estatística descritiva (voltada a compreender os dados a partir de certas medidas) e não da estatística inferencial (que desenvolve modelos voltados a identificar quais são as correlações que podem ser entendidas como relações de causalidade).

2.2 Estudo de caso

No caso do direito, muitas vezes não se conduz um estudo censitário nem um estudo com amostras aleatórias, mas o pesquisador escolhe realizar um estudo de caso, ou seja, realizar uma investigação acerca de um fenômeno específico.

Mirian Goldenberg explica que "o termo estudo de caso vem de uma tradição de pesquisa médica e psicológica, na qual se refere a uma análise detalhada de um caso individual, que explica a dinâmica e a patologia de uma doença dada" e que foi adaptado para as ciências sociais, tornando-se "uma das principais modalidades de pesquisa qualitativa" (2004). Trata-se de uma abordagem especialmente comum na pesquisa antropológica, visto que uma de suas principais estratégias é a imersão do pesquisador em uma comunidade para a realização de uma etnografia construída pela observação participante da sociedade estudada.

Como ocorre nas abordagens etnográficas, o estudo de caso não foca uma população de objetos, mas um objeto determinado: uma pessoa, um processo, uma decisão, uma coisa, uma família. Focar nas complexidades de um elemento específico limita a possibilidade de fazer inferências, já que o conhecimento acerca de um objeto particular dificulta sobremaneira a extrapolação esse conhecimento para outros membros da mesma população (de pessoas, de decisões, de sociedades, etc.).

Por mais que os casos escolhidos sejam considerados paradigmáticos, o pesquisador não tem como extrapolar, estatisticamente, as suas conclusões sobre o caso para a população de casos. Isso não significa, porém, que seja impossível a generalização das conclusões, mas apenas que toda extrapolação precisa ser feita com extremo cuidado.

Tal como em outras abordagens qualitativas, a generalização não segue as regras da inferência estatística, que são a marca distintiva dos métodos quantitativos. No caso dos métodos qualitativos, a passagem das observações sobre fenômenos particulares para um conhecimento geral acerca da população não é mediada pela noção de "significância estatística", mas por uma análise qualitativa, que atribui caráter significativo a um determinado conjunto de eventos, que pode ser chamado de amostra.

A seleção do conjunto de fenômenos a serem abordados costuma ser feita de forma deliberada, em um processo chamado de amostragem intencional, por meio do qual o pesquisador busca escolher aquelas que consigam propiciar os melhores dados para a pesquisa (ou seja, os dados mais relevantes, em maior volume e que ofereçam diversas perspectivas sobre o tema pesquisado) (Yin 2016). Neste tipo de abordagem, o pesquisador não objetiva estabelecer generalizações estatísticas, mas generalizações analíticas, que consistem em conectar os resultados da pesquisa aos conceitos ou construtos teóricos preexistentes e, quando forem convergentes com eles, argumentar sobre como esses conceitos e construtos se aplicam a outras situações, além daquela especificamente estudada.

Apesar desses cuidados, a generalização com base em um caso apenas, por mais exemplar que ele possa parecer ao pesquisador, é demasiadamente sujeita a vieses. Por isso, a relevância do estudo de caso está normalmente associada à existência de uma multiplicidade de pesquisas que tratam de objetos diferentes: vários casos de enfermidade, diversas sociedades tradicionais, variadas culturas jurídicas. Por mais que os estudos de caso analisem unidades particulares, eles tendem a ganhar relevância quando existe uma grande "população de pesquisas", que é uma característica dos campos em que esse tipo de abordagem ganhou proeminência, como nas ciências médicas e na antropologia.

A busca de estabelecer modelos mais abrangentes não ocorre nos próprios estudos de caso, mas em outras pesquisas, que comparam os resultados de várias investigações, na busca de descrever estruturas transversais e identificar padrões na população composta pelos objetos que foram efetivamente investigados.

O caso escolhido não deve ser entendido como uma amostra unitária porque todo estudo amostral é voltado a compreender as características de uma população, a partir de informações relativas a um subconjunto desse grupo. No estudo de caso, o objeto de pesquisa deve ser percebido como uma amostra, nem como um exemplo, nem como um modelo: ele precisa ser encarado como um objeto complexo, a ser interpretado por meio de uma combinação específica de estratégias, voltadas a compreender essa complexidade.

Um pesquisador que realiza um estudo de caso que se relacione com uma densa rede de outras investigações ganha a possibilidade de refletir sobre uma situação particular de forma comparativa, traçando aproximações e analogias com os resultados de pesquisas anteriores. No direito, porém, são poucos os âmbitos nos quais é possível contar com esse tipo de rede de investigações, que viabilize tais estratégias comparativas. Isso faz com que o estudo de caso esteja muitas vezes ligado a uma pretensão exploratória, voltada a mapear campos pouco estudados e que contam com repertórios conceituais pouco desenvolvidos.

O foco no caso pode ser muito relevante em tais pesquisas exploratórias, pois a restrição da amplitude é normalmente compensada por uma riqueza de análise, que pode explorar muitas conexões: históricas, sociológicas, econômicas, etc. Essa exploração intensiva (e não extensiva) tem a potencialidade de revelar uma série de conexões que podem ser posteriormente estudadas. Uma das vantagens do estudo de caso é que ele permite a multiplicação de estratégias (entrevistas, observação participante e levantamentos quantitativos, por exemplo), com o objetivo de oferecer uma descrição cuja complexidade possa tornar compreensível as situações particulares que fizeram o pesquisador entender que o estudo de um caso particular seria uma contribuição relevante.

Estudar um caso (especialmente quando o caso é um processo ou um julgamento) não configura um estudo de caso, exceto quando o pesquisador se dedica a gerar uma análise complexa e densa, entrelaçando várias perspectivas. Por isso, o estudo de caso nunca deve ser escolhido com uma forma de diminuir a complexidade do trabalho, visto que a sua realização somente é justificável quando ele serve para oferecer uma compreensão de múltiplas dimensões do mesmo objeto, de suas múltiplas relações com o ambiente.

No caso específico da dissertação baseada na combinação de artigos, é possível, como indica Maira Machado, usar o estudo de caso "como estratégia secundária ou complementar em um projeto adotando métodos múltiplos" (Machado 2017). Ele pode funcionar como elemento de pesquisa exploratória, voltada a definir as categorias a serem utilizadas em um estudo mais amplo. Contudo, dependendo da justificativa acerca do caráter heurístico do caso analisado, ele pode ser também a estratégia central da pesquisa.

Quando o estudo de caso ocupa o centro da pesquisa, o desafio de elaborar um bom projeto se intensifica, pois é preciso estabelecer com cuidado as estratégias de abordagem. Que perspectivas serão utilizadas? Que dimensões serão exploradas? Que categorias vão guiar essa exploração? Quais serão os dados levantados? Tudo isso precisa ser pensado com cuidado para que o estudo de caso tenha a densidade necessária para ser compreendido com uma investigação autônoma.

Note que a situação não melhora se você escolher alguns objetos, em vez de um só. É difícil justificar a escolha de um caso específico, mas é ainda mais difícil justificar a seleção de dois ou três casos individuais, que serão estudados com menos complexidade do que um caso único, mas que não representarão uma amostra válida. A definição de alguns objetos (especialmente de algumas decisões) é normalmente ditada pelo viés de seleção do pesquisador, que considera que esses objetos são exemplares ou paradigmáticos.

A extrapolação das conclusões de alguns casos selecionados por critérios intuitivos ou arbitrários é tão indevida quanto a extrapolação das conclusões sobre um caso particular. Contudo, quando estudamos um conjunto restrito de casos, podemos cair mais facilmente na tentação de considerar que se trata de uma amostra representativa. Assim, quando um projeto de estudo de caso é criticado por não ser justificada devidamente a sua relevância, a adição de mais alguns casos costuma piorar a situação, em vez de melhorá-la.

É possível que você tenha escolhido fazer um estudo de caso porque considerou ser importante dar uma maior divulgação ao objeto que você escolheu como caso: uma decisão que você pensa que não foi valorizada suficientemente, uma situação de abuso que as pessoas não conhecem, uma situação tão absurda que você entende que todos deveriam conhecer. Porém, devemos tomar cuidado com a ideia de que um caso é relevante porque ele não é suficientemente conhecido, visto que a sua percepção de relevância pode decorrer do fato de que aquele caso específico impactou a sua sensibilidade (por exemplo, por ter sido a primeira vez que você notou um fenômeno), mesmo que ele não seja particularmente relevante. Portanto, se você optar por um estudo de caso, dedique um cuidado especial para a sua justificativa, pois é bem provável que você seja questionado sobre a relevância dessa pesquisa para o campo do estudo que você propõe.

2.3 Abordagens sincrônicas e diacrônicas

Independentemente de adotar uma abordagem censitária ou amostral, a pesquisa observacional precisa definir o recorte temporal envolvido na investigação.

Podemos nos limitar a colher dados referentes a um momento determinado (o que nos levará a analisar a relação desses dados apenas nesse momento) ou colher informações referentes a momentos temporais diversos (o que nos possibilita identificar padrões de modificação dos fenômenos no tempo).

Nesse caso, podem ser analisados dados referentes a um momento determinado, que funcionam como uma espécie de “fotografia”. Isso ocorre, por exemplo, quando se analisa o conjunto de casos que estão na pauta de julgamento de um tribunal, para compreender a sua composição. Sampieri e outros chamam esse desenho de transversal, mas preferimos chamar de sincrônico, para acentuar que se trata de um levantamento de dados sobre uma situação fixada no tempo.

Tais abordagens se diferenciam das diacrônicas (chamadas por Sampieri de longitudinais), que levantam dados referentes a momentos diversos, o que permite efetuar análises das transformações dos dados ao longo do tempo. Isso ocorreria, por exemplo, se levantássemos os dados da composição da pauta do Conselho Especial do STJ na primeira semana de março dos últimos 20 anos, com o objetivo de mapear o modo como a composição da pauta se modificou durante esse período.

Os estudos diacrônicos são adequados para avaliar o modo como certos elementos variam, no curso de períodos predeterminados. No judiciário, eles são úteis para investigar objetos como a composição da pauta, as modalidades de decisão dos mandados de segurança, o número de processos ajuizados, os argumentos utilizados para extingui-los.

Muitas vezes, as abordagens sincrônicas só fazem sentido como parte de uma série de investigações, como ocorre nas pesquisas de intenção de voto. Cada uma delas é relevante pelo fato de medir as intenções em um momento determinado, mas a devida compreensão do fenômeno mapeado exige uma multiplicidade de pesquisas, que possibilitem compreender a evolução dessas intenções no tempo.

Você pode conduzir uma pesquisa sincrônica (por exemplo, sobre a composição dos estoques de processos nos gabinetes de um determinado órgão julgador, em um tempo determinado), que estará acoplada a outras pesquisas sincrônicas (que realizarão esse mapeamento relativamente a outros momentos). Ou você pode fazer uma pesquisa sincrônica quando levanta dados nos quais o tempo não é uma variável relevante: por exemplo, mapeando os julgamentos que foram realizados nos últimos dois anos por um gabinete, mas tratando esse conjunto como um grupo único, que não será segmentado por datas de julgamento.

A forma de abordagem dependerá do seu problema de pesquisa, e dos objetivos que você definiu para especificá-lo. Se algum dos seus objetivos envolve comparar situações em tempos diversos, você precisará inserir esse elemento diacrônico em sua abordagem. Já se os seus objetivos não implicarem esse tipo de comparação, a sua abordagem será sincrônica.

Em campos que tratam de características mais estáveis (como, por exemplo, a existência de vieses cognitivos ou o impacto de certos medicamentos em uma doença), abordagens sincrônicas são normalmente adequadas. No campo do direito, porém, é muito comum que o seu objeto de estudo varie bastante ao longo do tempo, o que aponta para a necessidade de realizar abordagens diacrônicas, para que sejam possíveis conclusões mais sólidas.

Inobstante, pode ser que a riqueza do seu trabalho esteja na comparação sincrônica de padrões de comportamento de diferentes órgãos, de diferentes tribunais ou em diversas regiões. Em casos como esses, é mais comum uma abordagem sincrônica porque a cumulação de dois níveis de comparação (diacrônico e sincrônico) eleva muito a complexidade do trabalho.

Além disso, o enfoque sincrônico pode ser justificado em pesquisas exploratórias pelo fato de que não se trata de buscar conclusões explicativas, mas apenas de identificar as categorias mais adequadas e os tipos de relação entre fenômenos que poderão ser utilizados para formular pesquisas capazes de gerar resultados descritivos mais sólidos, ou até mesmo explicativos.

2.4. A unidade de análise

As teorias científicas normalmente fazem afirmações acerca de uma classe de objetos: mamíferos, sistemas de governo, infecções virais, decisões de procedência. Cada classe nomeia um conjunto finito de objetos (todos os seres humanos, todos os processos do STJ, etc.) e um dos maiores desafios da ciência é conseguir fazer afirmações seguras sobre todos os membros de uma classe, a partir de pesquisas que avaliam somente um número relativamente restrito de situações concretas.

Uma vez escolhido o objeto de pesquisa, é preciso definir uma forma de descrevê-lo, o que nos coloca frente ao problema do “marco teórico”. Um dos pontos fundamentais desse marco é a descrição que fazemos do nosso objeto em termos de identificar os elementos que o compõem.

A pergunta sobre os “componentes” é necessária porque todo objeto de pesquisa é complexo, e pode ser subdividido nas unidades que o compõem. Uma classe processual é composta por uma série de processos individuais. Um processo é composto por peças, como a decisão. Uma decisão é composta por partes, como o relatório e o dispositivo. O dispositivo é composto por termos que, combinados, lhe dão um significado.

Por um lado, temos a intuição de que existe uma organização contínua que une todos esses elementos dentro de um sistema. Talvez exista uma ordem global que conecta os significados de cada uma das palavras de todos os dispositivos de cada um dos acórdãos do STJ que julgam Mandados de Segurança. Contudo, essa é uma ordem de tal complexidade que não é possível reconstruí-la por meio de uma pesquisa. Concatenar todos esses elementos dentro da mesma estratégia de abordagem provavelmente nos conduzirá a não perceber padrões nos dados que levantamos.

Por isso, precisamos escolher um nível de análise específico, que definirá o tipo de dados que vamos coletar e interpretar. Se eu defino o meu objeto de pesquisa como os “julgamentos de Mandados de Segurança realizados pelo STJ”, tudo indica que tomo o meu objeto como um “conjunto de decisões”, o que tipicamente me coloca o desafio de fazer uma coleta de dados que identifica uma série de decisões individuais. Essa forma de definir o objeto de pesquisa (um conjunto de decisões a ser mapeado) tipicamente estabelece o desafio de levantar dados acerca de todas as decisões que compõem esse conjunto (numa abordagem censitária) ou de um grupo determinado de decisões (numa abordagem amostral), para seja possível realizar uma operação indutiva: fazer uma descrição da população a partir de informações levantadas acerca de seus componentes.

Nesse tipo de escolha, a unidade de análise da pesquisa é a decisão. Os dados serão coletados com referência a decisões particulares e a pesquisa aposta que essa informação poderá me dizer algo relevante sobre o meu objeto.

Mas quais são os dados que eu vou coletar sobre essas variadas decisões? Isso dependerá do problema de pesquisa. Podemos coletar dados sobre as partes, sobre o valor da causa, sobre os impactos políticos do processo, sobre as características dos julgadores, sobre o número de palavras da decisão, sobre a existência ou não de referências a outros processos.

A única coisa certa é que você não coletará todos os dados possíveis, pois isso não seria factível. Se você tiver uma abordagem que pode dizer coisas importantes levantando apenas alguns dados simples (como nomes das partes ou modalidades de provimento), sua pesquisa será muito eficiente: dirá coisas importantes com um esforço pequeno.

Os dados referentes a cada unidade de análise dizem respeito ao que chamamos de variáveis, visto que as características específicas de cada uma das unidades (no caso, de cada decisão) são definidas pelos valores de cada uma das variáveis que definimos: data da sessão de julgamento, órgão julgador, número de ministros presentes, existência de votos divergentes, etc.

Para sermos mais precisos, as variáveis não são propriamente os dados, mas são categorias de dados. Os dados coletados são os valores que essas variáveis têm para cada uma das unidades de análise. Assim, a nossa unidade de análise são as decisões e podemos definir uma série de variáveis, que indicam quais são as informações a serem buscadas com relação a cada uma das decisões. E os valores são os dados específicos que as variáveis assumem com relação a cada unidade particular.

Mas há alternativas: em vez de coletar dados relativos a cada decisão, podemos coletar dados relativos a cada processo, o que conduz a uma abordagem diferente, pois o mesmo processo pode ter várias decisões e uma mesma decisão pode impactar processos diferentes (no caso de apensamento, conexão ou julgamento conjunto). Se eu escolher como unidade de análise o processo, pode ser que eu entenda que existe uma continuidade entre a decisão liminar e a decisão final (pois ambas se referem ao mesmo caso). Se eu escolher como unidade de análise a decisão, posso tratar a decisão liminar e a final como elementos diferentes, que terão atores e conteúdos próprios.

Um resultado bem diferente ocorreria se utilizássemos como unidade de análise os votos. Poderíamos entender que cada julgamento é um conjunto de votos e coletar dados no nível dos votos e não no nível dos processos ou das decisões. Cada uma dessas escolhas nos dará uma base de dados diferente: se construirmos uma tabela com essas informações, as unidades de análise tipicamente nos oferecem as nossas linhas, as variáveis são as nossas colunas e os valores são os dados contidos em cada célula.

A definição da unidade de análise gera variáveis muito diferentes, pois os atributos de decisões, de processos ou de votos são bastante diversos. Podemos classificar decisões em liminares ou definitivas, mas não podemos classificar processos usando essa categoria. Podemos classificar votos como divergentes ou convergentes, mas não podemos usar essa categoria para descrever os processos.

A escolha da unidade de análise é um dos elementos fundamentais do desenho da pesquisa porque os dados serão levantados tendo como referência essa unidade. No caso da pesquisa em direito, por exemplo, teremos resultados bem diferentes se usarmos como unidade de análise os processos ou se usarmos como unidade de análise os pedidos, visto que um mesmo processo pode julgar vários pedidos diferentes. Usando uma metáfora biológica, chamamos o conjunto de todos os objetos de uma mesma classe de população: quando escolhemos como unidade de análise os processos, nós coletamos dados que nos permitem falar de uma população de processos.

A maioria das nossas conclusões não terá validade para um objeto particular. Uma pesquisa exaustiva sobre padrões de julgamento pode permitir que se descubra que certos fatores tornam mais provável uma decisão de procedência, mas não permitem prever os resultados de um caso concreto. Não podemos prever com certeza qual será o impacto do uso de corticoides no tratamento de um paciente com Covid-19, embora haja estudos que indiquem que a maioria dos pacientes graves tende a ter resultados positivos com esse tratamento.

Quando falamos de tempo de tratamento ou de óbito, usamos categorias que somente se aplicam a pacientes concretos. Uma população não é tratada nem morre. Somente indivíduos são tratados por um certo tempo e podem morrer ou sobreviver. É a análise de uma série de situações particulares que nos permite fazer afirmações sobre a população, usando categorias que se aplicam no nível populacional: tempo médio de tratamento, mortalidade, índice de recuperação.

Denominamos modelo de dados essa definição de qual é a unidade de análise e quais são as variáveis que definem as informações que colheremos com relação a cada um dos elementos que compõem o nosso universo empírico.

3. Estratégias quantitativas e qualitativas

No exercício da construção de explicações que deem sentido aos dados coletados, identificando padrões nos fatos empíricos, existem basicamente dois tipos de estratégias:

- Interpretar os dados a partir do seu significado, em estratégias chamadas de qualitativas

- Interpretar os dados a partir de suas quantidades medidas, nas estratégias chamadas de quantitativas

3.1 Métodos quantitativos

Quando descrevemos os dados, podemos focar em realizar medições, que atribuem aos dados grandezas quantificáveis: número de ocorrências, tempo gasto nos julgamentos, número de citações, duração de processos. Essas grandezas numéricas possibilitam que os dados sejam compreendidos dentro de estruturas matemáticas e estatísticas, que comparam essas quantidades com certos padrões (médias, medianas, totais, desvios, etc.) e, com isso, possibilitam uma interpretação dos fenômenos com base em informações numéricas.

As abordagens quantitativas que são concentradas levantar dados que contenham medidas numéricas, e as técnicas de estatística inferencial (conclusões baseadas em metodologias estatísticas) tipicamente utilizam a comparação entre os padrões de variação de duas ou mais variáveis.

Por exemplo, pode ser que o tempo de julgamento de uma ação criminal varie no mesmo sentido que a renda média dos réus. Essa variação coordenada de duas variáveis é denominada correlação. Nesse caso específico, seria uma correlação positiva, pois o aumento na renda média dos réus estaria associado com um aumento no tempo de julgamento. Em outros casos, pode haver uma correlação negativa, o que indica que duas variáveis se movem em direções opostas: pode ser que descubramos empiricamente que, quanto maior a idade do réu, menores são os tempos de pena privativa de liberdade.

O problema das correlações é que elas não indicam claramente qual a relação entre os fatores relacionados. Pode ser que a renda média impacte no tempo de julgamento porque custa caro o acesso a advogados mais preparados e capazes de adiar o fim dos processos. Essa é uma hipótese que supõe a existência de relação causal entre o custo dos advogados e o tempo do processo, mas essa é uma causalidade que não é fácil demonstrar.

Por mais tentadora que seja essa interpretação, pode ser que os réus de alta renda estejam concentrados em tipos de crime que geram processos mais lentos, independentemente do perfil dos advogados envolvidos. Também pode ser uma combinação desses dois fatores (e de outros mais), que não geram uma variação suficientemente coordenada para que identifiquemos um impacto causal entre esses fatores.

Talvez os réus mais velhos cometam crimes menos violentos e isso seja a causa de eventuais penas menores, o que faria com que não houvesse relação causal entre as idades e as penas, mas apenas entre os graus de violência e o tamanho das penas. Nesse caso, a correlação entre a idade dos réus e o tamanho das penas seria espúria, já que crimes violentos cometidos por réus mais velhos poderiam ter duração tão grande ou maior do que crimes violentos praticados por pessoas mais jovens.

Quando entendemos adequadamente o nosso objeto de pesquisa, nos tornamos capazes de elaborar um desenho que teste a nossa hipótese e também as interpretações alternativas: por exemplo, podemos propor uma pesquisa que levante dados sobre a renda dos réus, o custo dos advogados e o tempo de julgamento de dois tipos diferentes de crimes (homicídio e tráfico de drogas, por exemplo). Se os padrões de variação do tempo de julgamento se mostrarem semelhantes, nos dois tipos de crimes, pode-se sugerir que a nossa hipótese original (de relação causal entre a renda dos réus e o tempo de julgamento) seria compatível com os fatos.

Em todos esses casos, trata-se de abordagens quantitativas porque é a variação nas quantidades (de tempo, de renda, de páginas, de citações) que nos serve como critério para interpretar os dados e enxergar padrões.

3.2 Métodos qualitativos

Nas estratégias qualitativas, o foco não está em interpretar grandezas numéricas, mas em compreender o significado de certos acontecimentos. Quando estudamos uma decisão paradigmática, podemos nos perguntar quais são os argumentos determinantes da decisão.

A resposta a essa pergunta dependerá de uma leitura crítica do caso, de uma identificação dos argumentos utilizados, de uma análise do impacto que eles parecem ter tido na formulação dos termos do acórdão e da ementa. As estratégias aqui estão voltadas para identificar argumentos relevantes, sendo que essa relevância não é mensurável em termos numéricos. Não é o fato de uma palavra ter sido repetida mais vezes, ou de um autor ter sido citado mais vezes, que lhes garante um papel central na estrutura retórica de um voto.

Quando nos perguntamos sobre o modo como a Assembleia Constituinte tratou a questão indígena, somos levados a efetuar uma leitura crítica dos Anais da ANC, buscando elementos que nos permitam compreender os variados discursos e os modos como eles se articularam. Pode não importar muito qual foi a quantidade de referências, sendo muito comum que os vários discursos sejam avaliados em termos de relevância ou centralidade, por critérios que dependem de fatores não quantificáveis.

Uma das abordagens qualitativas típicas é o estudo de caso, no qual uma determinada situação é avaliada em uma multiplicidade de dimensões (histórica, econômica, antropológica, etc.), com o objetivo de possibilitar uma descrição rica dos vários elementos que contribuem para que determinada situação (o caso estudado) tenha uma configuração específica.

Quando buscamos compreender qual é o modo pelo qual os contratos de locação tratam as obrigações tributárias (como o pagamento de IPTU), a questão não é a de medir quantidades, mas de compreender as várias maneiras pelas quais os contratos podem tratar essa questão. Nesse caso, uma estratégia comum é a de definir uma classificação, estabelecendo que certos contratos vão ser considerados como de um determinado tipo, enquanto outros contratos serão qualificados de forma diversa.

Os procedimentos de classificação merecem uma análise mais detida, pois eles são centrais em toda pesquisa. A classificação dos dados se dá quando o pesquisador insere conceitos capazes de promover uma segmentação dos fenômenos em diferentes classes, que precisam ser tratadas de modo independente para que a explicação faça sentido. Buscar explicações totalizantes para fenômenos diferentes termina nos levando a becos sem saída, em que não conseguimos visualizar padrão algum ou no qual identificamos padrões equivocados.

A formulação de classificações adequadas é provavelmente o ponto mais delicado das pesquisas qualitativas, e é também a sua principal interface com o referencial teórico, que é a fonte de várias classificações:

- tipos de processo,

- tipos de sentença,

- tipos de contratos,

- tipos de partes,

- tipos de interações.

Os tipos não existem empiricamente: eles são classificações linguísticas por meio das quais qualificamos os objetos estudados. Por serem construções linguísticas, esses tipos são partes integrantes das teorias, ou seja, dos modelos que usamos para descrever e explicar.

Teorias diversas nos dão modos diferentes de classificar os objetos, de hierarquizar as preocupações, de estabelecer conexões causais. As teorias nos oferecem os modelos pelos quais convertemos as nossas observações empíricas em uma descrição significativa. Por mais que as pesquisas nos coloquem diretamente em contato com as evidências, não podemos perder de vista que esse contato é mediado pelas categorias teóricas que conformam as nossas formas de ver o mundo.

3.3 Conexão entre perspectivas qualitativas e quantitativas

Ainda que a diferença entre abordagens quantitativas e qualitativas contribua para a nossa compreensão das pesquisas, o fato é que na maior parte delas esses elementos aparecem de forma combinada.

Por exemplo, temos uma pesquisa sobre ADIs no STF que busca traçar um perfil dos impetrantes, dividindo-os em demandantes de grande porte, de médio porte e de pequeno porte. Essa é uma distinção qualitativa (que usa 3 categorias), mas que adota critérios quantitativos (número de ações ajuizadas por ano) para poder classificar os demandantes.

Esse caso particular pode ser compreendido a partir de um fenômeno mais amplo: muitas das categorias qualitativas, que usamos para classificar os dados, são realizadas a partir de elementos quantitativos: idade dos envolvidos, número de processos ajuizados, número de votos divergentes, etc.

Enquanto muitas estratégias estatísticas comparam variações de quantidades numéricas, o direito muitas vezes precisa comparar elementos propriamente quantitativos (como o número de interrupções feitas ao voto do relator) com distinções qualitativas (como o gênero do relator ou sua cor). A busca de compreender o impacto de certas categorias qualitativas em variáveis quantitativas nos leva a ter de trabalhar muito bem com esses dois mundos, e de incluir nessa equação também os elementos teóricos que estão na base dessas classificações.

Por isso, ainda que seja importante compreender as metodologias quantitativas e qualitativas, é bastante provável que a sua pesquisa exija alguma combinação de grandezas numéricas e elementos categoriais, que geram modelos que precisam combinar essas duas perspectivas.

3.4 Para além dos rótulos

Em muitos projetos de pesquisa, um equívoco fundamental é a busca de esclarecer a metodologia por meio de alguns rótulos: método indutivo, método dedutivo, método histórico, ou qualquer outro título que não mostra muito sobre as efetivas estratégias que serão utilizadas. O uso dessas referências gerais, sem qualquer esclarecimento, normalmente indica um projeto que não foi suficientemente desenvolvido.

No projeto que você realiza, importa pouco o nome que você dá ao seu método. O que importa é a sua capacidade de estabelecer claramente estratégias de enfrentamento do seu problema.

Se você faz uma pergunta descritiva (por exemplo, sobre o modo como o STJ decide certas questões), a estratégia de abordagem deve indicar o modo como você pretende coletar os dados, classificá-los e organizá-los de forma a poder realizar o mapeamento que o seu problema propõe.

Se você cria uma hipótese a ser testada (por exemplo, que são concedidos mais mandados de segurança em certas condições), você precisa também explicar que dados levantará, como vai organizá-los e a que testes a sua hipótese pode ser submetida.

O importante não é dizer se você adotará uma perspectiva qualitativa ou quantitativa. O que é mais relevante é você indicar que tipo de classificação você pretende realizar (tipos de decisões, tipos de argumentos, tipos de petições) e quais são as grandezas você pretende medir (número de decisões de procedência, média de tempos de julgamento, etc.), com o objetivo de construir uma resposta adequada ao seu problema.